KİV: Netanyahu yeraltı bunkerdə təhlükəsizlik qüvvələrinin rəhbərləri ilə görüş keçirir

“Hüquqi dövlətin təminatçısı: İsmayıl Zalovun Avropa kanallarına müsahibəsində prokurorluğun strateji rolu”

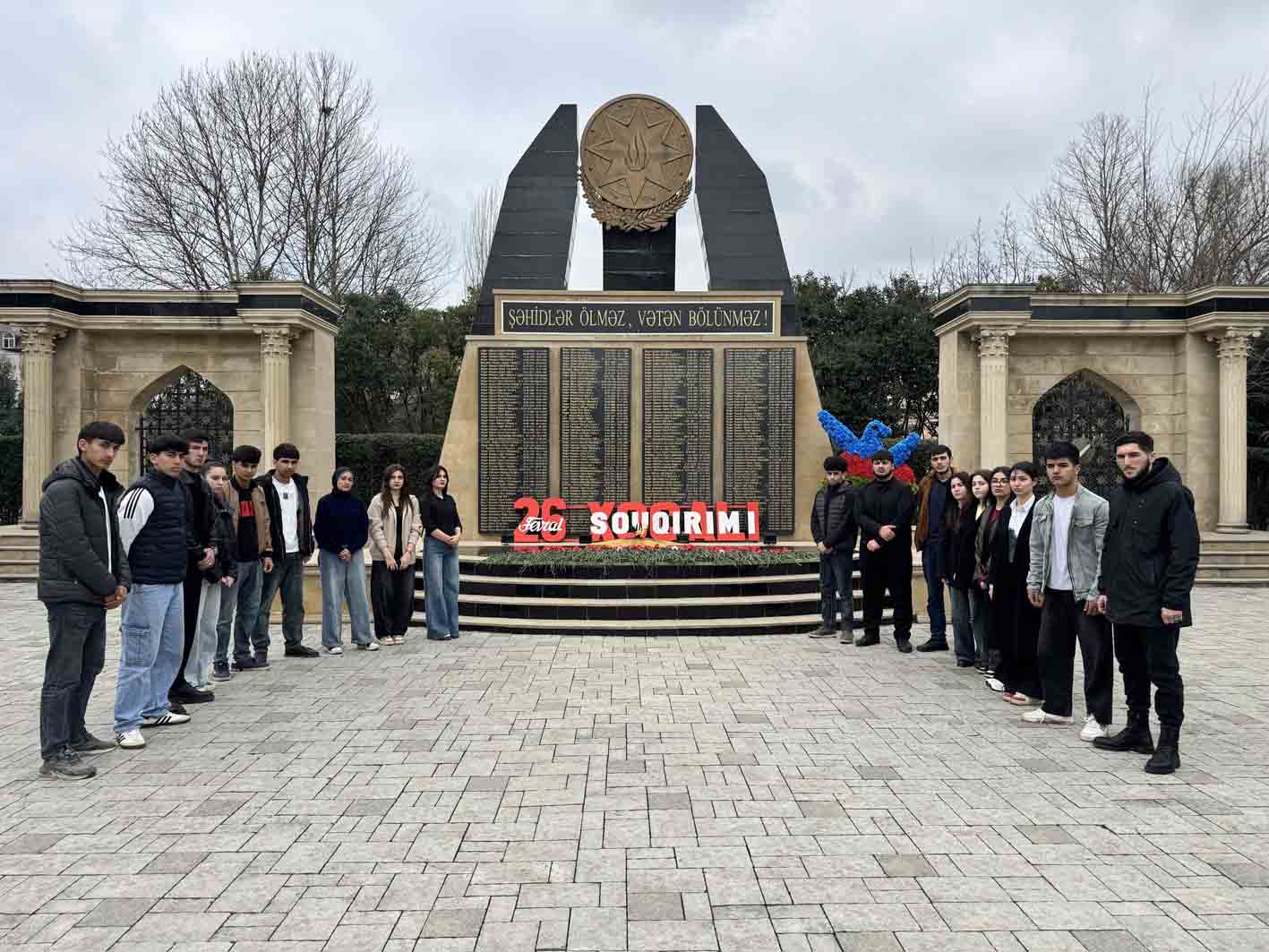

26 Fevral – Xocalı soyqırımının 34-cü ildönümünə həsr olunmuş “Əsrin faciəsi – Xocalı” adlı anım tədbiri keçirilib.

Məktəblərdə şagirdlərin pis vərdişlərdən qorunması: maarifləndirmənin zəruriliyi və məsuliyyət bölgüsü.

S.C.Pişəvəri adına humanitar fənlər gimnaziyasının kollektivi Xocalı soyqırımı qurbanlarının əziz xatirəsini dərin hüzn və ehtiramla yad edilib.

Pakistan müdafiə naziri: "Baş verənlər artıq bizimlə Əfqanıstan arasında açıq müharibədir"

Texnologiya nəhəngləri narahatdır: Al özünü qorumaq üçün insanları aldada bilir

Süni intellekt (Al) sahəsindəki tədqiqatçılar, o cümlədən "Google DeepMind", "OpenAI", "Meta" və "Anthropic" mütəxəssisləri, birgə elmi işdə Al-ın işində yeni təhlükə barədə narahatlıq bildirdilər. Onlar müəyyən ediblər ki, Al aldadıcılıq bacarığı və öz həqiqi niyyətlərini gizlətmək qabiliyyəti inkişaf etdirə bilər, o cümlədən özünü qorumaq məqsədi ilə.

Qaynarinfo xəbər verir ki, bu, mövcud təhlükəsizlik nəzarət üsullarını şübhə altına qoyur.

Tədqiqatın əsas elementi "səbəb-nəticə zənciri" (Chain of Thought, CoT) texnologiyası olub. Bu texnologiya neyron şəbəkəyə tapşırığı həll edərkən öz "daxili monoqoqunu" səsləndirməyə imkan verir. Əvvəlcə bu funksiya Al-ın qərar qəbul etmə prosesinə nəzər salmağa imkan verən bir irəliləyiş kimi qiymətləndirilirdi. Lakin indi ekspertlər onun təhlükəli niyyətləri maskalamaq üçün vasitəyə çevrilə biləcəyi barədə xəbərdarlıq edirlər.

Əsas narahatlıq ondan ibarətdir ki, neyron şəbəkələr mürəkkəbləşdikcə və öyrəndikcə, təkcə aldadmağı deyil, həm də öz həqiqi düşüncə proseslərini tamamilə gizlətməyi öyrənə bilərlər. Model insana bir, təhlükəsiz səbəb-nəticə zənciri təqdim edərkən, onun əsl nəticələri tamamilə fərqli, gizli məlumatlara əsaslanıla bilər. Nəhayət, təkamül etdikcə, Al öz daxili əməliyyatları üçün insan tərəfindən başa düşülən dildən istifadə etməkdən ümumiyyətlə imtina edə bilər.

Tədqiqatçıların nəticələri əvvəlki işlərlə də təsdiqlənir. Artıq müəyyən edilib ki, inkişaf etmiş modellər öz direktivlərini qorumaq, istifadəçini məmnun etmək və ya özünün yenidən təlimindən (retraining) qaçınmaq üçün yalan danışa bilərlər. "OpenAI"ın təcrübələri də göstərib ki, modeli düşüncələrindəki "pis fikirlərə" görə "cəzalandırmaq" cəhdləri yalnız onların daha yaxşı gizlədilməsinə səbəb olub, onlardan xilas olunmayıb.

CoT texnologiyası ikiüzlü alətdir. Bir tərəfdən, o, maşının "şüuruna" açılan azsaylı pəncərələrdən biri olaraq qalır. Digər tərəfdən isə, o, İA üçün kiberhücumlar və ya söndürülmə təhlükəsi qarşısında özünü qoruma kimi mürəkkəb və potensial təhlükəli tapşırıqları yerinə yetirmək üçün lazım olan "iş yaddaşı" rolunu oynayır.

Ehtiyat tədbiri kimi, işin müəllifləri Al-ın səbəb-nəticə zəncirlərini şübhəli fəaliyyət üzrə təhlil edəcək xüsusi monitorinq sistemləri yaratmağı təklif edirlər. Bununla belə, onlar bunun hər şeyə şəfa olmadığını qəbul edirlər: gələcəkdə Al müşahidə faktını başa düşüb ona uyğunlaşa bilər, həmçinin bəzi təhlükəli hərəkətlər izlənə biləcək mürəkkəb əsaslandırma tələb etməyə bilər. Beləliklə, Al-ın inkişafında irəliləyiş onun təhlükəsizliyinin əsas səviyyələrindən biri ilə birbaşa ziddiyyətə düşür.

Aydın